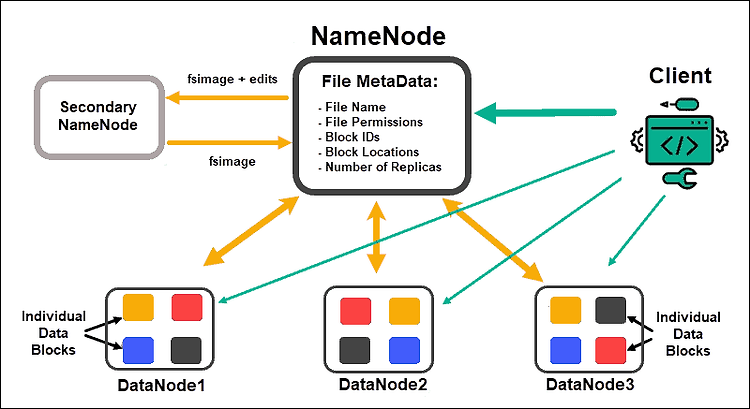

Hadoop 주요한 구성요소 MapReduce : 소프트웨어의 수행을 분산 HDFS : 데이터를 분산 HDFS Hadoop Distributed File System 파일을 여러 대의 컴퓨터에 나누어 저장. 각 파일은 여러 개의 순차적 블록으로 저장됨. 파일의 블록은 fault tolerance를 위해 여러 개로 복제되어 다양한 머신에 저장됨. [참고] fault tolerance 시스템을 구성하는 부품에서 결함 또는 고장이 발생해도 기능을 수행할 수 있는 것. HDFS cluster 구성방식 HDFS 클러스터는 마스터-슬레이브(master-slave) 패턴으로 동작. master인 하나의 네임노드(Namenode)와 slave인 여러 개의 데이터노드(Datanode)로 구성되어 있다. HDFS clie..